Incontable cantidad de datos brotan día con día, alrededor de nosotros; su origen no siempre es perceptible por parte de nuestros sentidos, en numerosas ocasiones ni siquiera es tangible. Los hábitos y conductas del ser humano son la raíz del complejo árbol de algoritmos que crece en los grandes servidores alrededor del mundo, donde los dispositivos portátiles han sido el abono más eficiente para impulsar y potenciar su crecimiento. El dato se volvió omnipresente, cada rincón del planeta se conectó, y de esta manera, nació un mundo insaciable de información.

Ante la abrumadora cantidad de datos, existe una herramienta que, a través del uso de procesos algorítmicos, es capaz de convertir una cifra en información; dicho instrumento lleva el nombre de Big Data. Los deportes no se encuentran ajenos a esta situación, están incursionado en el mundo de los datos masivos mediante grandes inversiones para el mejoramiento y automatización de los procesos que involucran al Big Data.

El Grand View Research, empresa de consultoría e investigación de mercado, mencionó en su informe de junio 2022 que espera que el tamaño del mercado mundial de la analítica deportiva alcance los 6 mil 340 millones de dólares en 2030, con lo cual regstrará una tasa de crecimiento anual compuesta del 27,1% entre 2022 y 2030.

¿Qué es el Big Data y cómo funciona?

El origen del Big Data no se puede reducir a un hecho en concreto, puesto que la multidisciplinariedad de este concepto permite que sea concebido desde diversas aristas a lo largo de la historia. Desde la creación de la contabilidad en la extinta Mesopotamia hasta el trabajo estadístico de John Graunt durante la peste bubónica, el manejo de grandes cantidades de información ha sufrido numerosas transformaciones según se expanden los conocimientos científicos aplicados al uso de la tecnología.

De acuerdo con el investigador Keith D. Foote, después de que John Graunt convirtiera en la primera persona en usar análisis de datos estadísticos, el mayor capítulo de evolución dentro de la historia del Big Data llegó hasta el siglo XX, con la llegada de la era de la información, apoyada por el desarrollo de computadoras, teléfonos inteligentes, Internet y equipos sensoriales, los cuales son los principales generadores de datos masivo de la sociedad contemporánea.

Uno de los precedentes con mayor trascendencia dentro de la historia del Big Data se dio en 1965, cuando Estados Unidos de América construyó el primer centro de datos, lo que significó un esfuerzo inicial para la recolección y almacenamiento de datos masivos. Keith D. Foote también asegura que esta iniciativa se formó con el objetivo de reunir millones de conjuntos de huellas dactilares y declaraciones de impuestos, donde cada uno de dichos registros se transfirieron a cintas magnéticas, para almacenarlas en una ubicación central.

El término Big Data fue mencionado formalmente por Roger Mougalas en 2005, quien lo usó para referirse a un gran conjunto de datos que, en ese momento, era casi imposible de administrar y procesar con las herramientas tradicionales de inteligencia disponibles. Un elemento crucial en la concepción del Big Data es que no solo se refiere solo a los datos en bruto sino a las técnicas por las cuales se obtienen conclusiones interesantes de esos datos que están, en algunos casos, en abierto.

Según el International Research Journal of Engineering and Technology, el Big Data es endémico de la Comunicación Digital y la Ciencia de la Información desde los primeros días de la Informática, y se define como una colección de conjuntos de datos o una combinación de conjuntos de datos que crecen día a día porque son creados por todos y para todo, desde dispositivos móviles, centros de llamadas, servidores web y redes sociales.

MapReduce se estableció como el modelo de programación básico por el que se llevan a cabo los procesos de Big Data y funciona de tal manera en que se programan aplicaciones que se ejecutan en paralelo para procesar grandes volúmenes de datos almacenados en clústeres, agrupación de ítems con característica similares o idénticas. Posteriormente, en el 2006, aparecería Hadoop, la primera primera plataforma Open Source enfocada al Big Data, la cual, gracias a su versatilidad, sentó las bases del procesamiento, análisis e interpretación del Big Data de la mayoría de fuentes digitales.

De acuerdo con Rubén Biselli y Mariana Maestri, en su obra La mediatización contemporánea y el desafío del Big Data, dentro del concepto del Big Data existe un encuentro entre dos áreas del saber: el informático computacional y las estadísticas; ambas áreas han trabajado paralelamente para sentar sus bases metodológicas y conceptuales, donde la automatización de los procesos se convirtió en el principal atractivo.

La estadística, desde sus inicios, ha funcionado con el objetivo de generar análisis y predicciones por medio de las variables numéricas recopiladas de los datos. Como una gran maquinaria técnica de recolección y procesamiento de datos, el Big Data, en conjunto con la estadística, irrumpió como una posible solución a los grandes problemas que padecieron las ciencias sociales, respecto a su fundamentación empírica, la cual, al estar basada en la experiencia, no arroja los datos precisos y certeros para actuar en consecuencia de la información proporcionada.

El autor Douglas da Silva, resume el papel estadístico del Big Data en cuatro tipos de análisis aplicables de diversas áreas de conocimiento: el predicitivo, el prescriptivo, el descriptivo y el diágnostico.

Los dos primeros análisis trabajan de manera conjunta, puesto que el análisis predictivo se encarga de realizar una predicción sobre posibilidades futuras, basándose en patrones encontrados en los datos que fueron analizados; mientras que el propósito del prescriptivo es presentar las posibles consecuencias que cada acción puede generar, lo que ayuda a elegir las estrategias más adecuadas, que generarán más y mejores resultados.

Por otro lado, el descriptivo tiene como objetivo aportar información sobre la situación presente a partir de datos históricos, es decir, este tipo de análisis contribuye a las decisiones que deben tomarse en tiempo real.

Finalmente, el análisis diagnóstico permite analizar los resultados y evolución de determinadas acciones. Con esto, es posible realizar ajustes a las estrategias que se están aplicando.

Influencia del Big Data en el deporte y sus principales virtudes

El Big Data dentro de la analítica deportiva desglosa las cifras recopiladas en distintas vertientes, dado que puede abarcar el historial de los rivales, la alineación de los jugadores, los registros de victorias y derrotas, así como varias métricas individuales de los jugadores, como la distancia recorrida, la velocidad, la resistencia, la aceleración, los niveles de energía, etcétera.

“El tema del Big Data no es algo nuevo en cuanto al deporte en general, porque tú ves en Estados Unidos la MLB, NFL, NBA y tienen demasiadas estadísticas, métricas o maneras de evaluar el rendimiento de un jugador. En el fútbol digamos que ha costado más trabajo llevarlo”, puntualizó Jorge Dennis, periodista y cofundador de la plataforma de visualización de datos mexicana, Statiskicks.

La importancia del Big Data en el desarrollo interno del deporte ha ido en aumento con el paso de los años, sobre todo con la creación de nuevos parámetros para monitorear el rendimiento individual o colectivo. El uso de Big Data puede ser beneficioso en términos de tiempo, ya que permite tomar decisiones con mayor rapidez que la obervación humana. Con el acceso a informes, números y estadísticas, se pueden obtener criterios y datos importantes en poco tiempo. La combinación de la programación y la inteligencia artificial evoluciona continuamente y simplica cada vez más los procesos.

Albert Blaya, periodista del medio digital Relevo, a través de su sección La Lupa, trabaja datos y estadísticas con la realización de análisis tácticos y estratégicos detallados de varios equipos, con el fin de entender a fondo las razones detrás de cada partido. Blaya destaca que el Big Data “es una fuente de conocimiento, que te permite desgranar la información”, es decir, en lugar de invertir tiempo innecesario en datos superfluos, se pueden analizar y seleccionar información importante y relevante en un mundo con una gran cantidad de datos e información disponible.

El aspecto económico es una pieza fundamental en todas las disciplinas de este ámbito; los proyectos a corto, mediano y largo plazo se rigen, además de los éxitos deportivos, por lo rentables que pueden llegar a ser. Para balancear las necesidades económicas con las deportivas, se encuentra la labor del scouting, práctica esencial en el mundo del deporte, que consiste en la búsqueda, evaluación y selección de talentos deportivos con el propósito de integrarlos a equipos o programas deportivos, donde barajan una serie opciones según las posibilidades económicas de la entidad.

El periodista Jorge Dennis explica que la clave del scouting está en la inversión precisa y consensuada, a través de los datos, de un jugador que solvente ciertas necesidades específicas. “Un jugador no por ser más caro, no por tener tales características es el mejor. Las estadísticas se hicieron para ver quién es más completo, para ver a un jugador que puede tiene ciertas deficiencias pero es posible ayudarle a que crezca profesionalmente y contrarreste dichas deficiencias a favor; finalmente, haces de un jugador que tenía ciertos de dificultades en un mejor deportista en el futuro”.

Uno de los más recientes exponentes de una gestión económica exitosa es Damien Comolli, exentrenador y scout de origen francés que impulsó el uso de la estadística avanzada en el fútbol a través del empleo las bases de datos del videojuego de simulación Football Manager. Durante su estancia en equipos como el Mónaco, Saint-Étienne, Arsenal, Tottenham Hotspur, Liverpool y Fenerbahçe, Comolli empleó su modelo deportivo y de negocios con base en inteligencia artificial y las cifras recopiladas por el Big Data.

Uno de los descubrimientos más importante en la carrera del francés fue el centrocampista croata Luka Modrić, quien dejó el Dinamo de Zagreb para ir al Tottenham Hotspur. Tras su paso por el equipo inglés, Modrić recaló en el Real Madrid, donde generó una ganancia de 12,50 millones de euros, según estimaciones del sitio web de transferencias alemán, Transfermarkt.

Además de las ganancias económicas que generó la venta del croata, como mencionó previamente Jorge Dennis, la gran aportación del scouting fue el impulso que se le dio a la carrera del jugador, ya que, tras asentarse en la élite futbolística con el Real Madrid, el croata se convirtió en uno de los mejores jugadores en su posición, donde fue reconocido con el Balón de Oro en 2018, el máximo galardón individual para un futbolista.

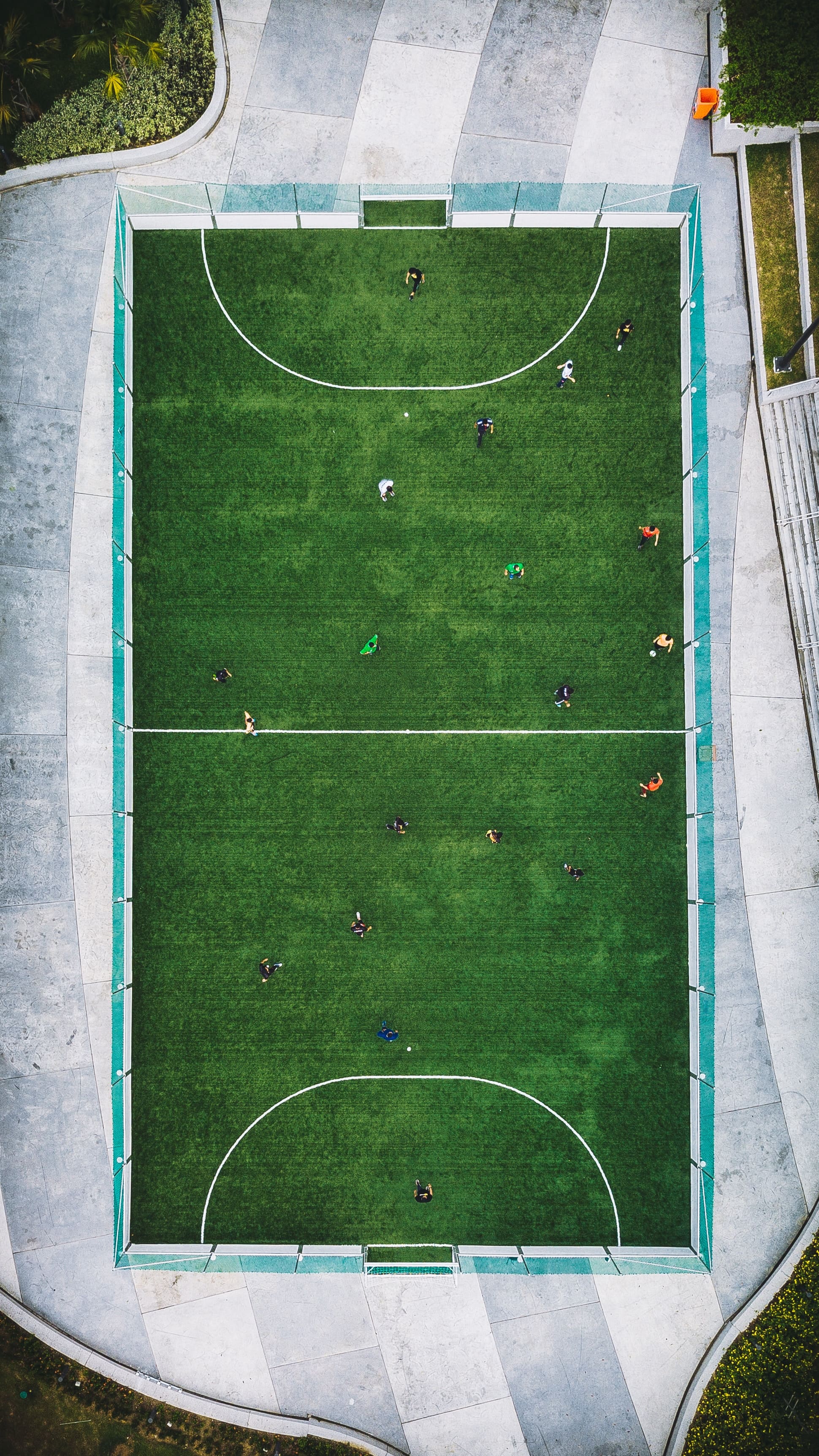

El proceso de democratización de los datos les ha permitido a los equipos e instituciones deportivas instaurar una división interna enfocada específicamente al Big Data, en la cual, a través de paquetes de datos otorgados por diversos proveedores, los analistas se encargan de ajustar sus informes en consecuencia de las cifras recibidas. Un claro ejemplo de este proceso se dio en España en el 2018, cuando La Liga Santander y La Liga 1|2|3, crearon la herramienta Mediacoach, en colaboración con el grupo de producción multimedia español Mediapro.

Con la finalidad de introducir novedades en la manera de preparar los encuentros y aumentar la habilidad de adaptación durante los mismos, el cuerpo técnico de los equipos de dichas categorías cuenta con la autorización de los dispositivos electrónicos en los banquillos, con los que tienen acceso a los datos técnicos proporcionados por Mediacoach, que incluye las estadísticas y el registro del estado físico de los futbolistas, tanto propios como rivales.

El funcionamiento de Mediacoach se basa en la instalación de seis cámaras en todos los estadios, las cuales son capaces de ubicar con una gran precisión la posición de cada uno de los jugadores que forman parte del partido, para así medir diversos parámetros, como la velocidad de movimiento, que incluye los arranques, frenadas y velocidad media. Posteriormente, dichas imágenes son comparadas con una base de datos que registra cada acción realizada por los jugadores, considerando la zona del campo en la que se produce.

La búsqueda de la estandarización del Big Data implica una importante inversión por parte de las entidades deportivas, sobre todo las que compiten al máximo nivel. Ante esta situación, donde pueden existir ciertas dificultades entre los competidores que no cuentan con el uso avanzado de los datos y los que sí, Guillermo Villar, periodista especializado en los datos, quien también forma parte del medio digital Relevo, considera que no disponer de las métricas avanzadas, ya sea a través de los proveedores mencionados o de otras bases de datos públicas, resulta una clara desventaja. “Todas las ventajas mencionadas se perderían. El análisis del dato es la forma de afirmar que unas impresiones son ciertas o no, y a veces los datos muestran lo contrario a las sensaciones en un inicio percibidas”.

Áreas de oportunidad del Big Data en los deportes

Como toda herramienta, el Big Data se encuentra constantemente en un proceso de mejorar, no sólo en aspectos técnicos, también en los metodológicos. El periodista Albert Blaya menciona que “las partes de mejora vienen a la hora de detectar la toma de decisiones del jugador, del deportista. En el caso del fútbol, está centrado en cómo mejorar a nivel individual ese rendimiento, de ayudar al futbolista, para que entienda dónde, cómo y cuándo hacer las cosas”.

Para abarcar todos los factores y variables posibles dentro del deporte, la evolución del Big Data exige la formulación de nuevas métricas que ofrezcan nuevas propuestas para la resolución de problemas y el mejoramiento individual o colectivo. Aterrizar la mayor cantidad de parámetros del rendimiento de un deportista en el ámbito cuantitativo es un reto mayúsculo, pero necesario para el crecimiento de la herramienta.

Otra de las nuevas métricas que enriquecen el análisis predictivo son Expected Goals, o Goles Esperados, un parámetro que ha ido adquiriendo reconocimiento por parte analistas y aficionados, debido a la precisa evaluación de lo que está ocurriendo sobre un terreno de juego. Abreviado como xG, los Expected Goals miden la probabilidad de que un disparo resulte en gol según la posición del futbolista que remata, la altura que viene el balón, la posición dónde se encuentra, si tiene un jugador enfrente o la distancia con la portería.

Roberto Testas, periodista de Canela Deportes, considera que también hay elementos que no se pueden cuantificar. “La intencionalidad de los jugadores, al menos en el fútbol, me da la sensación de que no se puede calificar las intenciones de muchos pases o de desmarques, también se sobrevaloran algunos aspectos, por ejemplo, en los Goles Esperados, los penales tienen un índice muy alto y creo que desvirtúan un poquito el análisis”.

Recientemente, el papel del aspecto psicológico en el deporte se ha vuelto más relevante e influyente, y se ha explorado como un área de oportunidad. Los equipos deportivos están contratando especialistas en ciencias cognitivas para ayudar a los deportistas a manejar el estrés y la presión en diferentes situaciones, no solo para proteger su bienestar mental, sino también para mejorar su rendimiento desde un enfoque diferente.

Tal es el caso de la campeona olímpica de bádminton, Carolina Marín, a quien le miden el sueño no solo para monitorear su descanso, sino también para crear un registro histórico con el objetivo de tener datos más precisos sobre cómo afecta el tipo y duración de descanso en su estado de ánimo y nivel de concentración, según contó Pedro de Alarcón, responsable del departamento de analítica deportiva de Telefónica, en una entrevista con El País.

Por otro lado, existe una aproximación distinta del apartado psicológico que también resultaría en una considerable área de oportunidad para el Big Data como herramienta y que además representa un enfoque cuantitativo. “En otros deportes se tiene muy presente el IQ y esto te ayuda mucho a saber qué tipo de personas estás trayendo al equipo o enfrentando en los entrenamientos. Influye totalmente en el rendimiento de un juego y de un jugador”, subraya el periodista Jorge Dennis.

Además de las oportunidades que ofrece el Big Data a través del apartado cuantitativo de las acciones que involucran los deportes, existe un elemento intrínseco en cada uno de los jugadores de las diversas disciplinas que los hace únicos e irrepetibles: el talento. Jorge Dennis destaca el valor innato del talento, y sostiene que “no hay manera, de momento, de manifestarlo en datos duros o cifras para un análisis desde un ángulo completamente objetivo”.

Transformación del periodismo

Otro sector que ha sido influencia de sobremanera por el uso de los datos y las estadísticas es el periodismo, del cual se originó una nueva vertiente: el periodismo de datos. Dentro de esta nueva dimensión, el algoritmo se está convirtiendo en la pieza esencial en la creación de la nueva contenidos informativos y comunicativos, ya que dichos algoritmos son capaces de hacer comprensibles y valiosos todos aquellos datos que son procesados, manejados, separados y cuantificados por medio de una computadora.

Con el Big Data se puede realizar una aproximación distinta para la elaboración de contenidos periodísticos, ya sean escritos o audiovisuales. La validación de la información a través de los procesos algorítmicos otorga una gran versatilidad a los trabajos presentados, puesto que la variedad de datos permite enriquecer la narrativa periodística desde múltiples ángulos y proporciona una comprensión más profunda y detallada de los resultados.

La profundidad con la que abordan ciertos contenidos puede resultar alienante para un sector del público, pero los periodistas pueden presentar datos complejos de manera más accesible y atractiva a través de las técnicas de visualización de datos. No obstante, para poder realizar este proceso de selección e interpretación, se requiere de un conocimiento previo de la naturaleza de los datos. Con base en el testimonio de los especialistas ntrevistados, para contar con dichas habilidades existen dos vías de aprendizaje: la empírica y la académica.

En la primera alternativa, Jorge Dennis, periodista de formación, destaca la importancia de conocer y consumir el deporte en el que se busca a través de los datos. “Lo que siempre me han dicho es ver fútbol, o sea, no nada más por saber lo que es una métrica o lo que es un dato ya sabes; tienes que ver también los partidos para seguir innovando, seguir procesando y seguir contextualizando toda la información de datos”.

El periodista debe familiarizarse con los datos y aprender a manipularlos para que muestren información sustanciosa, que cuente la historia detrás de ciertas acciones en el deporte y éstas resulten en un determinado acontecimiento, como el marcador de un partido o la actuación de un jugador. “Un dato aislado no te va a dar mucho pero si lo empiezas a relacionar a mezclar y le empiezas a dar forma ahí es donde realmente tú vas a poder manejar bien los los datos”, añadió Albert Blaya.

Por otro lado, por medio de la ruta académica, Guillermo Villar asegura que son muchas las cualidades que permiten dar el salto, como el conocimiento de bases de datos hasta herramientas específicas de análisis de datos y su visualización, pero lo más importante es proceder al análisis adecuado, saber presentarlo e interpretarlo”.

Las utilidades que otorga el Big Data han ayudado de gran manera a la labor periodística, como a reducción del tiempo dedicado a la investigación de datos duros; sin embargo, ante la aparición de estos automatismos, el papel del periodista, al igual que otras profesiones que son influenciadas por la tecnología, se encuentra en un estado de incertidumbre, dado que las responsabilidades de su disciplina cada vez podrían recaer más sobre el uso de dicha tecnología.

Francisco Javier Gónzalez, comentarista deportivo y director editorial de TUDN, menciona que no necesariamente la profesión del periodista se ha visto desplazada ante la irrupción del Big Data. “El trabajo del analista o el ojo experimentado de un entrenador es importante. La herramienta es un complemento, un área de apoyo”.

La convivencia entre ambos elementos es parte de la transición de la disciplina periodística a la era digital. Con el paso de los años, los avances tecnológicos no hacen más que enriquecer el trabajo de las profesiones y apoyarla para estacimar recursos. “El Big Data aporta y enriquece la información. Es un plus para que el lector o televidente tenga más datos acerca de lo que sucede en la cancha; es una herramienta que complementa el trabajo del periodista”, añadió Gónzalez.

Prospectiva

El Big Data ha crecido a pasos agigantados gracias al aumento del interés por parte de las empresas y, por consiguiente, la inversión que se le ha realizado también es mayor. La automatización de procesos, la estandarización de las plataformas de consumo y la participación de la inteligencia artificial son algunos de los resultados de la evolución de esta herramienta en los últimos años, lo que ha permitido que se expanda hacia múltiples direcciones.

Entre la baraja de opciones, la integración orgánica de la herramienta es un elemento fundamental. En el desarrollo profesional de los deportistas, Albert Blaya considera que “el siguiente paso el Big Data yo creo que sería el intentar acercarse más al deportista, el hacer que sea útil para el jugador en su día a día, de cómo poder ayudarlo en la toma de decisiones, en la mejora de rendimiento individual. También al entrenador de ¿qué puedo hacer para este partido en concreto?, no tanto para el largo plazo, sino para preparar el siguiente partido, el siguiente entrenamiento”.

Por otro lado, los medios de comunicación también evolucionarán a la par de las disciplinas deportivas, donde el Big Data ocupe un rol más importante en la elaboración de contenidos audiovisuales, como menciona el periodista Guillermo Villar, quien asegura que “cada vez más los medios apuestan no solo con una persona sino con equipos completos, para incluir estas métricas avanzadas en un medio diariamente”.

Del mismo modo, la especialización del periodista abarcará, además de la cobertura de un deporte en específico, el manejo de los datos y los programas para procesarlos. “Que en el periodismo deportivo cada experto en un deporte tenga a su vez la habilidad de tratar las métricas que este genera para ir un paso más allá en sus historias”, destactó Villar.

El potencial del Big Data como producto comunicativo es enorme y las formas de consumirlo, al igual que las plataformas de streaming, se instalarán en el imaginario colectivo de los aficionados. Francisco Javier Gónzalez considera que el Big Data debe “ser más interactivo con el consumidor. Que los estadios y equipos vendan la experiencia del Big Data. Dar el paso 100% digital”.

El árbol del Big Data ha echado sus firmes raíces dentro del mundo deportivo, y sus ramas frondosas proveen un valioso fruto que ayuda a todos los implicados en la industria a comprender mejor lo que sucede dentro de los terrenos de juego. La extensa y variada información permite que la esencia misma del deporte llegue a aquellos que lo sienten con pasión y entusiasmo.

Texto escrito por Santiago Sande. Apasionado de contar historias a través del periodismo, sobre todo en el ámbito deportivo, el cual lo ha convertido en el comunicador que es. El cine y los videojuegos son sus otras grandes aficiones, porque son capaces de transportarnos a relatos más alla de nuestro razonamiento. En Futbolinha realiza contenido a través de redes sociales acerca de lo que pasa más allá de los terrenos de juego.